Google stawia na sztuczną inteligencję. Wiele nowości w wyszukiwarce

W środę Google zaprezentował nowe możliwości sztucznej inteligencji w swoich produktach i usługach. Zdaniem firmy, wyszukiwarka, Mapy Google, Tłumacz będą bardziej intuicyjne dzięki wykorzystaniu AI. Koncern pokazał też, jak na sztucznej inteligencji może skorzystać kultura.

Dwa miesiące temu firma OpenAI udostępniła swój generator tekstu ChatGPT, którego w styczniu używało 100 mln użytkowników (z czego 13 mln codziennie). To najszybciej zyskująca popularność usługa internetowa.

Google w odpowiedzi na ten trend właśnie zapowiedziało testy własnego chatbota. Bard, bo tak się nazywa, ma działać w oparciu o język aplikacji LaMDA i docelowo zostać dołączony do wyszukiwarki. Koncern podkreśla, że zależy mu na tym, by skomplikowane zagadnienia chatbot wyjaśniał przystępnym językiem.

W środę podczas konferencji w Paryżu przedstawiciele Google'a opowiedzieli nieco więcej na temat Barda, a także wykorzystania sztucznej inteligencji w innych usługach koncernu.

W wydarzeniu wzięli udział Prabhakar Raghavan i Liz Reid, wiceprezesi odpowiedzialni za wyszukiwarkę, Chris Phillips, wiceprezes odpowiedzialny za produkty i usługi Geo oraz Marzia Niccolai, menadżerka produktu Google Arts & Culture.

Od zdjęć po filmy – jak AI pomaga w wyszukiwaniu z wykorzystaniem obrazu

Usługi Google, jak podkreśla firma, łączy jeden cel: jak najlepiej pomagać użytkownikom zarówno w ważnych, jak i mniej ważnych momentach. Google twierdzi, że od dawna wierzy w to, że sztuczna może przyspieszyć osiągnięcie tego celu.

Od początku istnienia wyszukiwarki AI pomaga w takich zadaniach jak rozumienie języka, sprawiając, że wyniki są bardziej przydatne dla użytkowników. Dzięki wieloletniemu rozwojowi dzisiejsze AI potrafi zrozumieć różnorodne formy informacji – od rozumienia języka i obrazu przez rozumienie filmów aż po rozumienie świata rzeczywistego.

Jeśli coś widzisz, możesz to wyszukać

Aparaty wbudowane w smartfony to świetne narzędzie, które pomaga w eksplorowaniu otaczającego nas świata. Użytkownicy zainteresowani tym, co mają przed oczami lub co widzą na zdjęciach, korzystają z Obiektywu Google ponad 10 miliardów razy miesięcznie. Google chce, aby Obiektyw – zdjęcie po zdjęciu – stał się furtką do globalnych zasobów informacji. Już teraz bezpośrednio z paska wyszukiwarki można użyć Obiektywu, aby dowiedzieć się, na co właśnie skierowany jest aparat lub co jest na zdjęciu. W ramach najnowszej aktualizacji dodana zostanie możliwość wyszukiwania tego, co jest widoczne na ekranie telefonu.

W najbliższych miesiącach Google planuje wprowadzić na Androidzie korzystającą z Obiektywu funkcję wyszukiwania na ekranie. Ta technologia pozwala na wyszukiwanie zdjęć i filmów ze stron i aplikacji widocznych na ekranie, np. czatu i rozmów wideo, bez konieczności zamykania aplikacji czy strony.

Łączenie różnych opcji wyszukiwania

Dzięki funkcji multiwyszukiwania użytkownicy mogą jednocześnie szukać za pomocą zdjęcia i tekstu, co zdaniem Google'a daje zupełnie nowe sposoby na wyrażenie tego, co mają na myśli. Multiwyszukiwanie jest teraz dostępne na urządzeniach mobilnych we wszystkich językach i krajach, w których można korzystać z Obiektywu Google.

Ostatnio Google wzbogacił multiwyszukiwanie o opcję wyszukiwania lokalnego. Jeśli użytkownik chce wspomóc lokalną firmę albo szybko coś kupić, wystarczy wybrać zdjęcie i dopisać „w pobliżu”, aby otrzymać wyniki lokalne. Ta funkcja jest na razie dostępna w języku angielskim w USA, ale koncern planuje udostępnić ją globalnie w najbliższych miesiącach.

„Czasem zdarza się też, że w trakcie wyszukiwania coś innego przyciągnie Twoją uwagę lub Cię zainspiruje. Z myślą o takich sytuacjach w najbliższych miesiącach wprowadzimy na urządzeniach mobilnych możliwość użycia funkcji multiwyszukiwania z każdym obrazem widocznym na stronie wyników wyszukiwania.

Wyobraź sobie, że szukasz „pomysłów na nowoczesny wystrój salonu” i Twoją uwagę przykuwa stolik kawowy, ale przydałby Ci się w innym kształcie, na przykład kwadratowy zamiast okrągłego. Przy użyciu multiwyszukiwania możesz dodać tekst „kwadratowy”, aby znaleźć idealny mebel. Sprawiamy, że proces wyszukiwania staje się bardziej naturalny, intuicyjny i wizualny. Ale to tylko ułamek technologicznych możliwości. Dziś dzięki Obiektywowi możemy wyszukać to, co widzimy. W przyszłości – dzięki AI – możliwości będą nieskończone”.

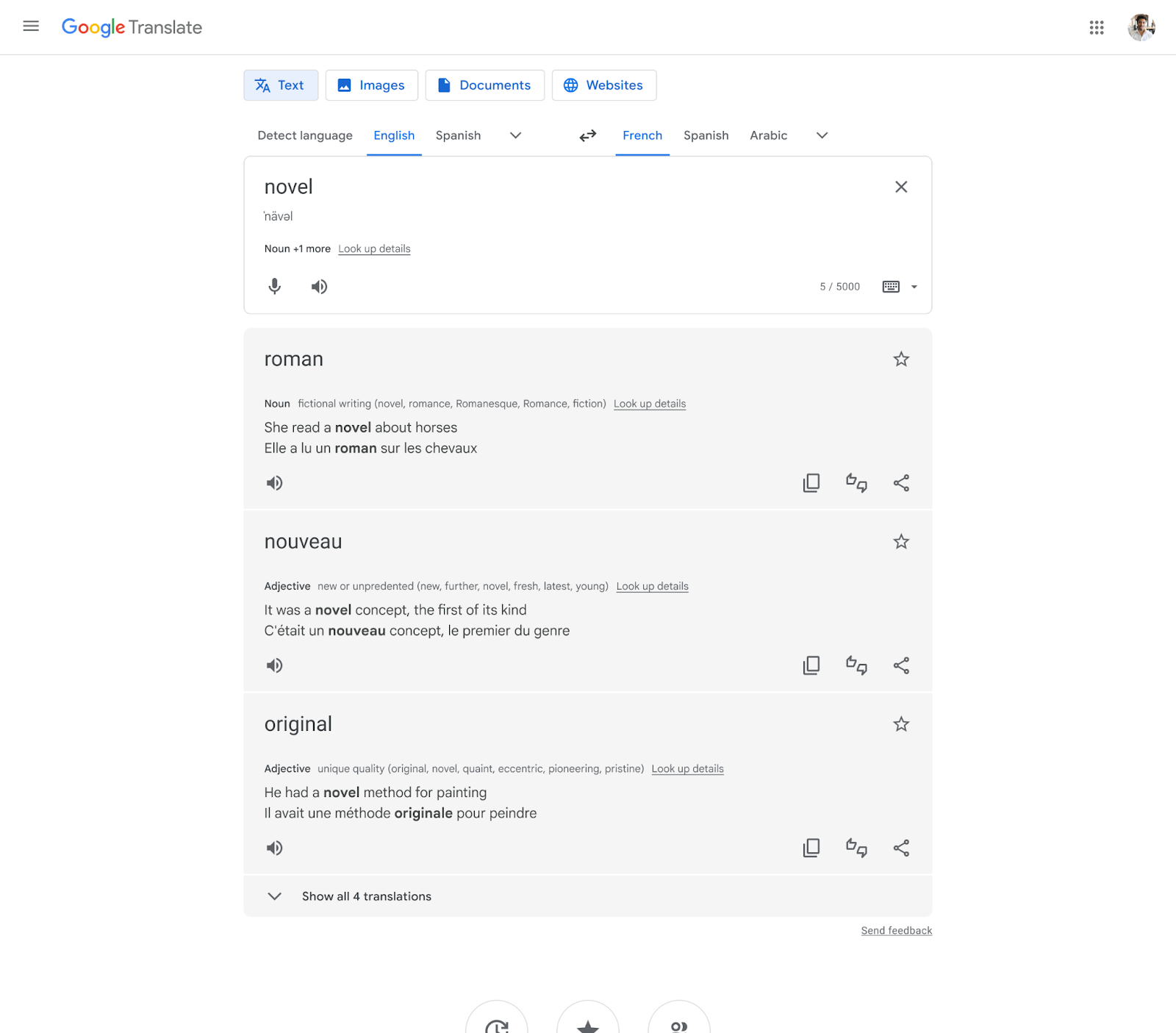

Nowe funkcje Tłumacza Google

Od czasu udostępnienia Tłumacza Google kilkanaście lat temu sztuczna inteligencja, jak podkreśla koncern, pomogła poczynić ogromne postępy w dziedzinie tłumaczenia. Dziś Google udostępnia kolejne funkcje oparte na tej technologii, aby zapewnić użytkownikom przydatny kontekst podczas korzystania z Tłumacza na telefonach oraz w przeglądarce.

Więcej kontekstu, lepsze tłumaczenie

W tym miesiącu w Tłumaczu Google dodane zostaną opcje tłumaczenia kontekstowego obejmujące opisy i rozmaite przykłady w języku docelowym. Teraz, gdy użytkownik będzie tłumaczyć tekst o żurawiu z królestwa ptaków, będzie mieć odpowiedni kontekst, który pozwoli odróżnić go od żurawia z placu budowy. Tłumacz podpowie odpowiednie sformułowania, idiomy stosowane przez rodzimych użytkowników języka oraz stosowne słowa. W najbliższych tygodniach funkcja ta będzie dostępna w tłumaczeniach na język angielski, francuski, hiszpański, japoński i niemiecki.

Niedawno aplikacja Tłumacz Google na Androida zyskała nowy wygląd. Wkrótce odświeżony interfejs aplikacji zobaczą też użytkownicy urządzeń z iOS. W nowej odsłonie Tłumacza użytkownicy mają większe pole do wprowadzania tekstu oraz ułatwiony dostęp do funkcji tłumaczenia rozmów, mowy oraz tekstu ze zdjęć zrobionych Obiektywem Google.

Nowe gesty: aby korzystanie z Tłumacza było wygodniejsze, wprowadzono obsługę nowych gestów: język można wybrać za pomocą mniejszej liczby kliknięć – wystarczy przytrzymać przycisk języka, a następnie przesunięciem palca szybko wybrać ostatnio używany język, natomiast przesunięcie palcem w dół w obszarze pola tekstowego na ekranie głównym pozwoli wyświetlić ostatnie tłumaczenia.

Większa przejrzystość: przetłumaczony tekst jest teraz bardziej czytelny dzięki dynamicznej czcionce, która dostosowuje się podczas wpisywania tekstu. Wyświetlane są też alternatywne tłumaczenia i definicje słownikowe (jeśli są dostępne), które ułatwią odkrywanie różnych znaczeń.

Nowe pakiety językowe: Google dodał obsługę 33 nowych pakietów językowych. Są to m.in. baskijski, hawajski, hmong, jidysz, korsykański, kurdyjski, luksemburski, łacina, sundajski i zulu. Można je pobrać na urządzenie i korzystać z nich w trybie offline lub w przypadku słabego połączenia z siecią.

Większe możliwości tłumaczenia tekstu z obrazów

Postępy w dziedzinie technologii sztucznej inteligencji umożliwiły Tłumaczowi Google tłumaczenie tekstu ze zdjęć zrobionych przy użyciu aplikacji Obiektyw Google, która umożliwia wyszukiwanie tego, co widzi użytkownik, za pomocą aparatu urządzenia. Zaawansowane systemy uczące się pozwalają łączyć przetłumaczony tekst z obrazem, dzięki czemu takie obrazy wyglądają bardziej naturalnie. Niedawno firma rozbudowała również funkcję tłumaczenia tekstu z obrazów dostępnych w internecie, aby zapewnić więcej opcji tłumaczenia treści internetowych opartych na obrazach, niezależnie od sposobu ich wyszukiwania.

Jak zapowiada Google, w tym roku koncern będzie w dalszym ciągu eksperymentować z funkcjami Tłumacza opartymi na sztucznej inteligencji, aby zapewnić jeszcze szybsze, dokładniejsze i bardziej dynamiczne tłumaczenia w aplikacji użytkownikom z całego świata.

Mapy bliższe użytkownikom i środowisku

W zeszłym roku Google podzielił się swoją wizją dotyczącą przyszłości Map Google. Firma pragnie, aby stały się one wciągającym i intuicyjnym narzędziem do poznawania świata i poruszania się po nim, a także pomocą w dokonywaniu bardziej zrównoważonych wyborów. Teraz koncern chce pokazać, jak ta wizja jest realizowana dzięki AI. Ulepszono widok imersyjny oraz funkcję Live View oraz dodano wskazówki dla właścicieli pojazdów elektrycznych, jak również pieszych, rowerzystów i użytkowników transportu publicznego.

Nowa funkcja: widok imersyjny

Widok imersyjny umożliwia odkrywanie różnych miejsc w zupełnie nowy sposób – sprawia, że użytkownik może z bliska poznać dane miejsce, jeszcze zanim się w nim znajdzie. Korzystając z możliwości AI i technologii rozpoznawania obrazów, widok imersyjny może scalić miliardy zdjęć Street View i zdjęć lotniczych, aby tworzyć szczegółowe cyfrowe modele miejsc z całego świata. Nakłada też na nie przydatne informacje np. na temat pogody, korków czy natężenia ruchu odwiedzających w wybranym miejscu.

„Załóżmy, że planujesz wizytę w amsterdamskim Rijksmuseum. Możesz wirtualnie unieść się nad budynkiem muzeum i sprawdzić z góry, gdzie znajdują się wejścia. Suwak czasu umożliwi Ci jednocześnie sprawdzenie, jak to miejsce wygląda o różnych porach dnia oraz jaka będzie pogoda. Dowiesz się również, kiedy w muzeum jest najbardziej tłoczno, a więc uzyskasz mnóstwo informacji przydatnych do podjęcia decyzji na temat najlepszej pory i miejsca odwiedzin. A jeśli zgłodniejesz, obniż lot do poziomu ulic i sprawdź okoliczne restauracje – możesz nawet zajrzeć do ich wnętrz, aby poznać panujący w nich klimat, zanim zarezerwujesz stolik”.

Aby stworzyć te realistyczne obrazy, Google korzysta z technologii sieci neuronowych (NeRF), czyli zaawansowanych funkcji AI, które przetwarzają oryginalne zdjęcia w obrazy 3D. Dzięki NeRF możemy dokładnie odwzorować dane miejsce, w tym jego oświetlenie, teksturę materiałów oraz elementy w tle. Technologia ta pozwala więc zajrzeć do baru i sprawdzić, czy panująca w nim atmosfera będzie odpowiednia na randkę, lub wirtualnie odwiedzić kawiarnię i upewnić się, że jest to dobre miejsce na lunch z przyjaciółmi.

Widok imersyjny jest dostępny już dziś w Londynie, Los Angeles, Nowym Jorku, San Francisco i Tokio. W nadchodzących miesiącach Google będzie udostępniać tę funkcję w kolejnych miastach, takich jak Amsterdam, Dublin, Florencja i Wenecja.

Poznawaj świat i nawiguj, korzystając z AR – we wnętrzach i na zewnątrz

Wyszukiwanie w trybie Live View wykorzystuje AI oraz rzeczywistość rozszerzoną, aby pomóc znaleźć użytkownikowi miejsca wokół niego, takie jak bankomaty, restauracje, parki i przystanki. Wystarczy, że idąc ulicą, uniesie telefon. Niedawno wdrożono wyszukiwanie z Live View w Londynie, Los Angeles, Nowym Jorku, San Francisco i Tokio, a w kolejnych miesiącach planujemy wprowadzenie tej funkcji w Barcelonie, Dublinie i Madrycie.

W najbliższych miesiącach wyszukiwanie za pomocą funkcji Live View będzie dostępne w Barcelonie, Dublinie i Madrycie.

Rzeczywistość rozszerzona jest wyjątkowo przydatna, gdy użytkownik wybiera się w nowe i skomplikowane miejsce np. na lotnisko, na którym będzie pierwszy raz. Aby ułatwić poruszanie się w takich miejscach, w 2021 roku wprowadzono funkcję Live View we wnętrzach na terenie Stanów Zjednoczonych, Zurychu i Tokio. Strzałki wykorzystujące rzeczywistość rozszerzoną wskazują korzystającym drogę i umożliwią szybkie i pewne odnalezienie najbliższej toalety, miejsca odpoczynku, postoju taksówek czy wypożyczalni samochodów.

W kolejnych miesiącach Google chce wprowadzać Live View w ponad 1000 nowych wnętrz – na lotniskach i dworcach kolejowych oraz w centrach handlowych w Barcelonie, Berlinie, Frankfurcie, Londynie, Madrycie, Melbourne, Paryżu, Pradze, São Paulo, Singapurze, Sydney, Tajpej i Tokio.

Ułatwienia dla pojazdów elektrycznych

Z obserwacji firmy wynika, że coraz większa liczba kierowców i firm motoryzacyjnych „przesiada się” na pojazdy elektryczne. Postanowiono więc wprowadzić nowe funkcje dla kierowców, którzy posiadają pojazdy elektryczne z wbudowanymi Mapami Google:

Wyszukiwanie postojów na ładowanie dla krótszych tras. W przypadku każdej trasy, podczas której konieczny będzie przystanek na ładowanie, Mapy zasugerują najlepsze miejsce, biorąc pod uwagę aktualny ruch na drodze, poziom naładowania oraz przewidywane zużycie energii. Google zapewnia, że można już przestać martwić się ładowaniem pojazdu, bez względu na to, dokąd się wybiera.

Stacje bardzo szybkiego ładowania. Wybierając w opcjach ładowania filtr „bardzo szybko”, z łatwością znajdziesz stacje wyposażone w ładowarki o mocy 150 kW lub większej. W przypadku wielu pojazdów jest to moc ładowania, która umożliwia powrót na trasę w niespełna 40 minut.

Stacje ładowania w wynikach wyszukiwania. Teraz miejsca ze stacjami ładowania, np. supermarkety, pokażemy Ci również w wynikach wyszukiwania. Wybierając sklep spożywczy, możesz wybrać taki, przy którym można naładować samochód.

Dzięki łatwo dostępnym wskazówkom, użytkownicy mogą śledzić swoją trasę z poziomu podglądu trasy lub przy zablokowanym ekranie. Mogą w ten sposób sprawdzić aktualny szacowany czas dotarcia na miejsce oraz kolejny zakręt – czyli informacje, które do tej pory były dostępne dopiero po otwarciu aplikacji i wejściu w tryb nawigacji. A jeśli postanowią nagle zmienić drogę, automatycznie zaktualizowane zostaną wskazówki. Te szybkie i czytelne wskazówki będą dostępne już w najbliższych miesiącach na urządzeniach z Androidem i systemem iOS. Będę też działać z funkcją Live Activities na urządzeniach z systemem iOS 16.1.

.gif)

9 sposobów wykorzystania AI w świecie kultury

Od 2018 roku Laboratorium Google Arts & Culture bada zastosowanie sztucznej inteligencji (AI) i systemów uczących się w kontekście artystycznym i kulturowym. Sztuczna inteligencja jest jednocześnie narzędziem i współpracownikiem. Podobnie jak wcześniej inne rewolucyjne technologie otwiera niezliczone możliwości przed artystami, technologami i instytucjami kultury. Jest wykorzystywana w ramach procesu twórczego, pomaga sprostać wyzwaniom, a nawet służy do nawiązywania kontaktu z odbiorcami.

Wiele projektów Google'a, które są efektem współpracy z różnego rodzaju artystami i artystkami oraz instytucjami kultury, powstało z chęci znalezienia odpowiedzi na postawione sobie pytania: Jak to jest usłyszeć kolor? W jaki sposób archiwum artysty może być inspiracją w procesie twórczym? Czy w muzeum można znaleźć swojego sobowtóra? W jaki sposób można zwizualizować kryzys klimatyczny? Jak nakłonić ludzi z pokolenia Z do śpiewania arii operowych? Jak kuratorzy sztuki mogą pokazać nam utracone dzieła?

Firma podkreśla, że tego typu pytania nurtują ją od lat i najczęściej to sztuczna inteligencja odegrała kluczową rolę w opracowaniu projektów i eksperymentów, które pomogły znaleźć na nie odpowiedzi.

Sztuczna inteligencja jako narzędzie do stawiania czoła wyzwaniom

Spośród 7 tysięcy języków używanych obecnie na ziemi ponad 3 tysiące jest zagrożonych wymarciem. Woolaroo to narzędzie typu open source, które pomaga społecznościom językowym chronić język i poszerzać listę używanych w nim słów. Obecnie narzędzie to obsługuje 17 języków, w tym m.in. jidysz, kreolski luizjański, maoryski, nawat, rapanui, sycylijski, tamazight czy Yang Zhuang. Woolaroo to projekt, który korzysta ze wspomaganego sztuczną inteligencją rozpoznawania obrazów, aby identyfikować obiekty w kadrze i dopasowywać je do stale powiększającej się biblioteki słów.

Kobiety, które zasłynęły w dziedzinie nauki, często nie otrzymują zasłużonego uznania. Dlatego we współpracy z kuratorami z Instytutu Smithsona Google opracował narzędzia oparte na systemach uczących się, które pomagają odkryć wcześniej nieznany wkład kobiet w świat nauki. Zapewniają one kuratorom i pracownikom naukowym zajmującym się danymi możliwość analizowania i wizualizacji danych kulturowych obejmujących niemal dwa stulecia.

Trzy arcydzieła Gustava Klimta – Medycyna, Prawoznawstwo i Filozofia – zostały zniszczone podczas II wojny światowej. Po tych niezwykłych dziełach sztuki (nazywanych „obrazami wydziałowymi”) zostały jedynie artykuły z ich opisami oraz czarno-białe zdjęcia. Dzięki systemom uczącym się i ścisłej współpracy z ekspertami z wiedeńskiego Belwederu zajmującymi się twórczością Klimta pracownikom Google'a udało się wirtualnie odtworzyć te dzieła słynnego artysty.

Sztuczna inteligencja została również wykorzystana do zidentyfikowania dzieł sztuki uchwyconych na starych fotografiach znajdujących się w zbiorach muzeum MOMA, przeanalizowania ogromnych zbiorów danych zgromadzonych przez magazyn LIFE oraz uporządkowania archiwum obrazów NASA, które teraz ma przystępną, interaktywną i zaskakującą formę.

Eksperymenty wykorzystujące sztuczną inteligencję jako nowy sposób obcowania z kulturą w świecie online

Blob Opera to wykorzystujący systemy uczące się zabawny eksperyment, który przekształca muzyczne pomysły w piękny harmonijny śpiew operowy. Najlepsze jest to, że wcale nie trzeba umieć śpiewać. Google użył głosów czterech profesjonalnych śpiewaków i śpiewaczek operowych, aby wytrenować „sieć neuronową”. Nauczono algorytm śpiewać i harmonizować 4 różne typy głosów oraz dodano syntezę śpiewu – obszar sztucznej inteligencji skupiający się na tym, jak komputery mogą modelować ludzki śpiew. Blob Opera – cyfrowe narzędzie dla każdego, bez względu na umiejętności muzyczne – jest używane zarówno przez nauczycieli podczas zajęć, jak i profesjonalnych artystów czy amatorów.

Art Selfie otwiera drzwi do świata sztuki, pokazując obrazy, na których twarz do złudzenia przypomina naszą. Gdy zrobimy sobie selfie, model systemów uczących się porówna nasze zdjęcie z twarzami znajdującymi się na dziełach sztuki udostępnionych nam przez współpracujące z nami nad tym projektem muzea. Po krótkiej chwili wyświetlą się nam wyniki wraz z wartością procentową określającą wizualne podobieństwo między naszą twarzą a wybranymi dla nas obrazami. Następnie możemy kliknąć dany obraz, aby dowiedzieć się więcej o nim samym oraz artyście, który go namalował.

A gdyby tak można było usłyszeć, jak brzmi kolor? Dzięki tej współpracy z Centrum Pompidou i systemom uczącym się możesz (prawdopodobnie po raz pierwszy w życiu) doświadczyć synestezji, którą był obdarzony Wassily Kandinsky, i „usłyszeć”, jak brzmi jego arcydzieło „Żółty – czerwony – niebieski”.

Innym projektem, który w zupełnie nowy sposób łączy ludzi z kulturą, jest Giga Manga. Pomaga on tworzyć niepowtarzalne postacie z mangi z pomocą systemów uczących się. Wystarczy naszkicować kilka prostych linii i dodać trochę kolorów, a potem pozwolić systemom uczącym się zająć się resztą. Natomiast po sukcesie projektu Art Selfie stworzyliśmy także Art Transfer i Pet Portrait.

Sztuczna inteligencja wykorzystywana przez artystów w pracy twórczej

To narzędzie do tworzenia choreografii oparte jest na sztucznej inteligencji i powstało we współpracy ze znanym choreografem Wayne’em McGregorem. Generuje prawdziwy ruch inspirowany archiwum McGregora, tworząc żywy dialog między tancerzami i tancerkami i jego 25-letnim dorobkiem.

POEMPORTRAITS to dzieło zbiorowe online stworzone przez artystkę Es Devlin we współpracy z Laboratorium Google Arts & Culture i technologiem Rossem Goodwinem. Umożliwia tworzenie wierszy z pomocą sztucznej inteligencji. Projekt ten jest dostępny online i obecnie znajduje się w centrum sztuki Barbican Centre w Londynie, gdzie stanowi część instalacji dostępnej w ramach wystawy

,,AI: More than Human”

Gdyby to owady zapylające projektowały ogrody, co zobaczyliby ludzie? To jedyne w swoim rodzaju dzieło sztuki o nazwie Pollinator Pathmaker, stworzone na zlecenie ogrodu botanicznego Eden Project mieszczącego się w Kornwalii we współpracy z artystką Alexandrą Daisy Ginsberg, wykorzystuje narzędzie algorytmiczne, które pomaga projektować ogrody z myślą o zagrożonych wyginięciem pszczołach i motylach.

Poprzez granty, które Goole przyznajew ramach programu Artists and Machine Intelligence (AMI), wspiera osoby ze świata sztuki wykorzystujące systemy uczące się w tworzonych przez nich pracach. Pokazuje to różne możliwości stosowania sztucznej inteligencji w tej dziedzinie. Od 2019 roku zróżnicowana grupa artystów i artystek z całego świata współpracuje z zespołem kreatywnych technologów Google, badając zastosowanie technik systemów uczących się w filmach, poezji, sztuce dźwiękowej oraz interaktywnym opowiadaniu historii.

Google zapewnia, że będzie nadal badać możliwości, jakie oferuje sztuczna inteligencja na styku sztuki i technologii.

W czwartym kwartale ub.r. przychody z wyszukiwarki Google zmalały rok do roku z 43,3 do 42,6 mld dolarów. Łącznie koncern przy wzroście przychodów o 1 proc. do 76,05 mld dolarów zanotował spadek zysku netto z 20,64 do 13,62 mld dolarów.

Newsletter

Newsletter

Max rusza w Polsce z 27 tys. godzin treści. Będą zmiany w Playerze

Max rusza w Polsce z 27 tys. godzin treści. Będą zmiany w Playerze  Koniec HBO Max. Jak korzystać z platformy Max?

Koniec HBO Max. Jak korzystać z platformy Max?  Sądowa porażka szefa KRRiT. Pieniądze dla TVP nie trafią do depozytu

Sądowa porażka szefa KRRiT. Pieniądze dla TVP nie trafią do depozytu  Były prezenter TVP w Polsacie. Poprowadzi dużą transmisję

Były prezenter TVP w Polsacie. Poprowadzi dużą transmisję  Z TVP odchodzi były dziennikarz „Wiadomości”. Pracował ponad 15 lat

Z TVP odchodzi były dziennikarz „Wiadomości”. Pracował ponad 15 lat

Dołącz do dyskusji: Google stawia na sztuczną inteligencję. Wiele nowości w wyszukiwarce